Новая эра SEO: влияние AI-контента на ранжирование

Сегодня мы наблюдаем бурный рост объемов контента, созданного искусственным интеллектом. Раньше тексты писали только люди. Теперь к ним присоединились нейросети. Они научились генерировать статьи, посты и даже рекламные сообщения в один клик. Казалось бы, такая скорость впечатляет и открывает большие возможности, но есть и обратная сторона медали — все больше SEO-специалистов и редакторов сталкиваются с просадками в позициях, отказами от текстов и «пустым» трафиком.

Биржа контента eTXT одной из первых отреагировала на эту новую реальность: сегодня мы уже тестируем комбинированные модели работы автор + AI и вводим дополнительную проверку качества статей, чтобы отделять полезные тексты от некачественной генерации.

На примерах из практики eTXT мы разберем, какие риски несет волна сгенерированного контента, как не потерять конверсии и почему без живых копирайтеров и редакторов все-таки не обойтись.

Рост интереса к ИИ-текстам: статистика

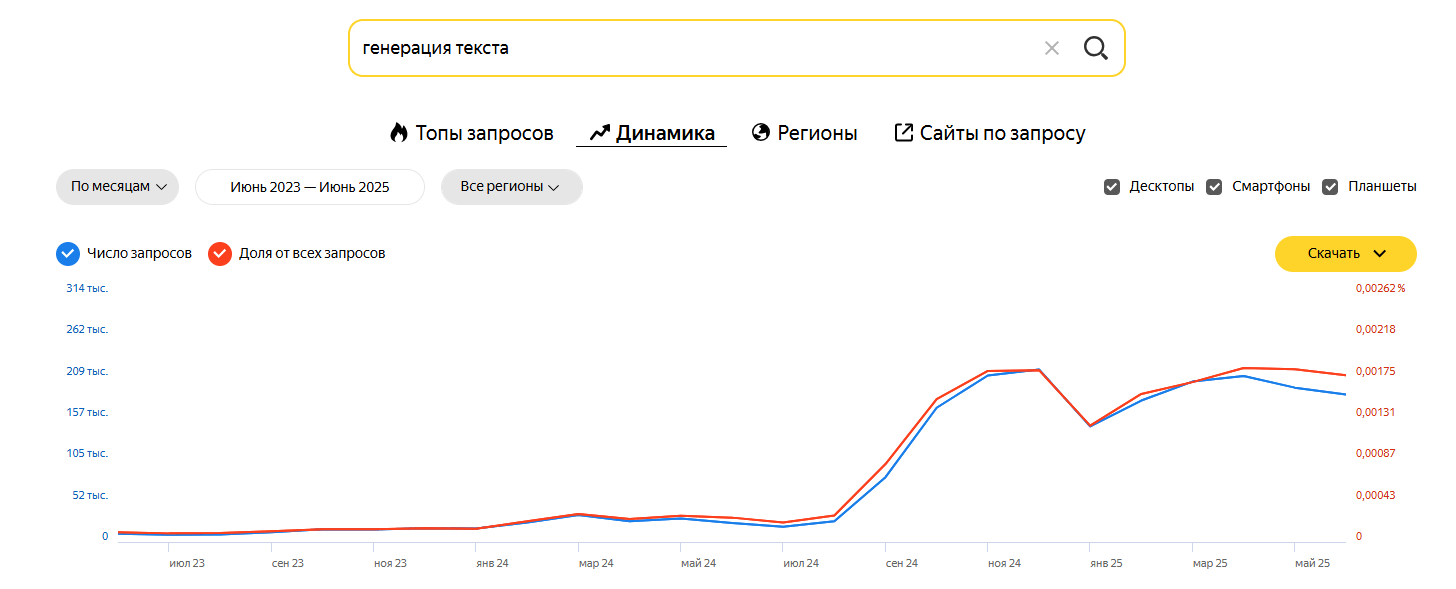

Для наглядности мы решили проанализировать данные поиска Яндекса, введя запрос «генерация текста». Анализ показал, что с июня 2023 года по июнь 2025 года количество таких запросов выросло более чем в 10 раз.

Если в июне 2023 года число запросов «генерация текста» составляло всего 10 493, то в июне 2025 года по этому запросу искали информацию уже 186 595 раз. Несомненно, в это число попали не только уникальные запросы (это не означает, что написание текстов нейросетью искали 186 тыс. новых пользователей), но стремительный рост интереса к ИИ-текстам очевиден.

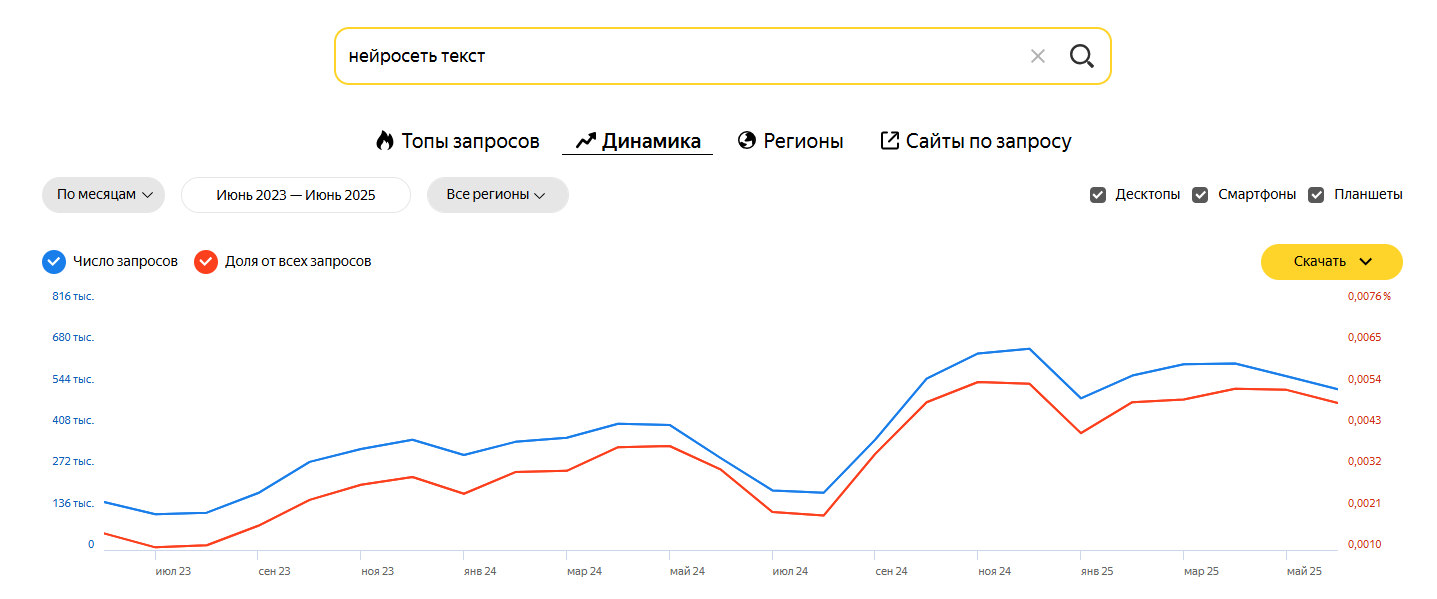

Аналогичную картину мы видим при поиске данных по запросу «нейросеть текст». С 157 871 в июне 2023 года частотность запроса выросла до 528 135 в июне 2025 года.

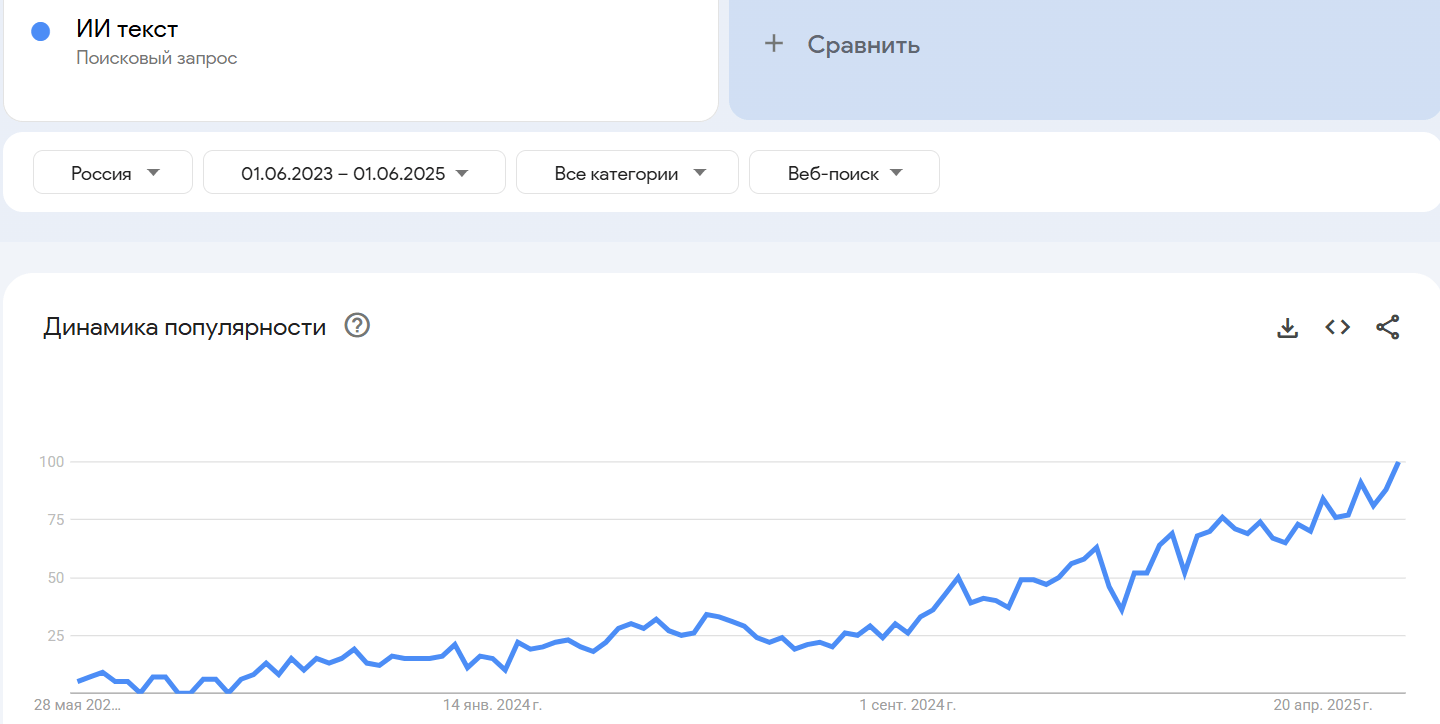

Анализ ключа «ИИ текст» в Google Trends также показал активный рост интереса пользователей к созданию текстового контента при помощи нейросетей за последние годы.

Такая популярность генерации статей не могла не сказаться на структуре контента в поисковой выдаче. Далее мы приводим конкретные цифры по доле сгенерированного контента в разных нишах. Однако сначала предлагаем рассмотреть основные плюсы и минусы написания текстовых материалов при помощи ИИ.

Преимущества использования нейросетей для создания текстов

Нейросети открывают новые возможности в сфере контент-маркетинга и SEO, обеспечивая быстрое и масштабное производство текстов. Мы собрали несколько наиболее значимых преимуществ использования AI-систем для генерации контента:

- Высокая скорость создания текстов — нейросети могут выдавать сотни и даже тысячи слов всего за несколько секунд. Это особенно удобно, когда нужно быстро реагировать на инфоповоды или закрывать большой пул запросов.

- Экономия ресурсов — цена ИИ-текстов заметно ниже, так как не нужно привлекать авторов и оплачивать их работу.

- Универсальность — нейросети обучаются на больших объемах данных, поэтому могут генерировать тексты практически на любую тему, от описаний товаров до информационных статей в блог.

- Генерация идей — ИИ можно использовать не только для создания самого текста, но и для «мозгового штурма». Например, нейросеть может предложить список идей для статей или несколько вариантов цепляющих заголовков. Это в разы ускоряет и упрощает работу с контентом.

Какие минусы есть у ИИ-текстов

Несмотря на все преимущества, тексты, сгенерированные нейросетями, имеют ряд недостатков. Вот главные из них:

- Ограниченная глубина экспертизы — нейросеть пока не может заменить эксперта. Особенно если речь идет о редких или узкоспециализированных темах. Модель, обученная на общих данных, обычно дает поверхностные ответы.

- Фактические ошибки — ИИ совмещает данные из разных источников и может путать контексты. Отсюда неверные даты, искаженные факты, путаница в цифрах. Если не проверять информацию, можно ввести читателей в заблуждение.

- Отсутствие «человеческого» стиля — сгенерированный текст часто выглядит «искусственным», монотонным. Выдает его обилие громоздких конструкций и канцелярит — либо же наоборот, обрывистые короткие фразы.

- Проблемы с уникальностью — из-за того что нейросети обучаются на уже написанных материалах, сгенерированный текст не всегда получается уникальным.

- Не всегда актуальная информация — как показывает практика, нейросетевые модели могут не учитывать последние события или изменения в отрасли. Если обучение проводилось до выхода определенной новости или обновления, бот выдаст устаревшую или неточную информацию.

Доля ИИ-контента в разных нишах

Сгенерированные тексты уже повсюду — но насколько они действительно проникли в топ поиска? Чтобы проверить это, специалисты Биржи контента еТХТ провели анализ выдачи. Результаты оказались неожиданными даже для нас — нейросети пишут больше, чем можно было предположить. При этом сгенерированный контент занимает лидирующие позиции в поиске. Но обо всем по порядку.

Цель анализа: оценить долю AI-контента в топе-10 поисковой выдачи по высокочастотным запросам и понять, как это влияет на ранжирование.

Схема отбора: в четырех нишах («Информационные технологии», «Маркетинг», «Медицина», «Финансы») выбрали по пять статей из топа-10 для дальнейшего анализа.

Инструмент: каждую публикацию проверили своим AI-детектором, который показывает долю сгенерированного текста.

Использование нейросетей для создания контента дает много преимуществ, но требует осознанного подхода. Автоматическая генерация пока еще не может заменить человеческую экспертизу и «живое» редактирование.

Статьи, созданные ИИ, часто нуждаются в доработке, проверке фактов и корректировке стилистики.

Результаты анализа

| Ниша | Средний % AI-контента в выборке | Доля статей, сгенерированных на 80% и более | Min / Max |

|---|---|---|---|

| Информационные технологии | 73,6 % | 70 % (3/5) | 21 % / 99 % |

| Маркетинг | 87,4 % | 80 % (4/5) | 74 % / 100 % |

| Медицина | 76,2 % | 60 % (3/5) | 29 % / 96 % |

| Финансы | 72,6 % | 60 % (3/5) | 31 % / 99 % |

По результатам исследования пришли к следующим выводам:

- высокая доля сгенерированного контента стала нормой. В среднем три из четырех статей в каждой категории содержат 80 % машинного текста;

- маркетинг — абсолютный лидер: 87 % текста в топовых публикациях написано ИИ, и даже самая «человечная» статья здесь на 74 % сгенерирована;

- разброс внутри ниш — попадаются и «чистые» статьи (доля машинного текста < 35 %), и почти полностью сгенерированные. Однако и те и другие попали в топ выдачи. Это говорит о том, что не процент ИИ решает судьбу страницы, а общая полезность такого контента.

Таким образом, ИИ-контент уже стал частью поисковой экосистемы. Нет сомнений, что внедрение искусственного интеллекта продолжит набирать обороты, и уже в ближайшие годы мы увидим дальнейшее увеличение доли AI-контента. По мнению некоторых экспертов, уже в 2026 году искусственный интеллект будет создавать до 90% интернет-контента.

Сферы с низким порогом входа и высокой необходимостью масштабирования (маркетинг, e-commerce) показали особенно стремительный рост. Ниши с высокими требованиями к достоверности (медицина, научная журналистика) сохраняют более медленные темпы. В сложных экспертных областях все еще нужна проверка фактов и тщательное редактирование. При этом алгоритмы не наказывают за происхождение материала — они награждают за полезность. Поэтому оптимальная модель работы в 2025 году — «нейросеть + копирайтер + редактор»: машина экономит время, а человек отвечает за качество получившегося текста.

Как поисковые системы относятся к AI-текстам?

Многие SEO-эксперты сходятся во мнении, что для современных поисковых систем в первую очередь имеет значение не метод создания контента (руками или ИИ), а его качество.

Автоматизация без качественной редактуры дает однообразные и перефразированные тексты, которые часто выглядят «пустыми». Специалисты отмечают, что если AI-текст действительно содержит полезные инсайты, проверенные факты и структурированную информацию, то поисковики относятся к нему как к любому другому контенту. По этой причине большое значение для продвижения в поисковой выдаче имеет «доработка» AI-контента: нужно проверять факты, вносить дополнительную экспертизу, приводить примеры из реального опыта и делиться ценными кейсами.

Еще один важный вывод — поисковые системы стараются понять, насколько контент отвечает реальным запросам пользователей. Если текст, сгенерированный нейросетью, хорошо отвечает на вопрос или решает проблему, его шансы занять высокие позиции будут почти такими же, как и у «ручного» текста.

Поисковики, особенно Google, уделяют все больше внимания E-E-A-T (опыт, компетентность, авторитетность и достоверность). Искусственный интеллект может делать заготовки, но в текст все равно нужно «добавить» авторитетность: упоминания, ссылки на проверенные источники, факты. Тогда шансов занять место в топе выше.

У экспертов есть разные гипотезы, как именно поисковики могут вычислять и «наказывать» за некачественный AI-контент.

Например, Google и Яндекс используют передовые алгоритмы для понимания структуры текста. Это помогает выявлять «водянистость», многократные повторы ключевых фраз, шаблонность слога.

Также поисковые системы могут анализировать аномальную скорость публикации большого объема однотипных материалов, структуру семантики, статистические закономерности в синтаксисе и т. д. Если алгоритм видит резкие всплески неестественных сигналов — это может вызвать подозрение и привести к ухудшению позиций.

Андрей Хайсанов, SEO-эксперт: «При работе с нейросетями очень важно соблюдать принцип “доверяй, но проверяй”. Искусственный интеллект действительно может ощутимо упростить и ускорить процесс создания контента, но в темах, требующих особой точности (например, медицина или право), важно уделять особое внимание фактчекингу и привлекать опытных редакторов для доработки материалов. Нейросети — это всего лишь инструмент, а главными принципами при создании контента остаются авторитетность и экспертная оценка. Поисковые системы учитывают эти факторы, поэтому профессиональные копирайтеры и дальше будут востребованы. При этом главным критерием по-прежнему остается качество: мы пишем для людей, и читатели должны оставаться довольны результатом».

Подытоживая все вышесказанное, можно сделать следующие выводы касательно ранжирования ИИ-контента в выдаче:

- У поисковиков нет предвзятости к AI-контенту. У многих складывается ошибочное мнение, что сами по себе сгенерированные тексты уже являются поводом для бана или занижения страницы в выдаче. Однако, если материал хороший, экспертный и отвечает на главный запрос, поисковые системы не будут к нему придираться.

- Даже самые продвинутые нейросети могут допускать фактические ошибки, стилистические огрехи, смысловые повторы и «лить воду». Эксперты рекомендуют вручную редактировать сгенерированные тексты.

- Google и Яндекс развивают алгоритмы, способные глубже понимать смысл текста. Это означает, что в долгосрочной перспективе примитивный AI-контент без добавленной ценности будет ранжироваться хуже.

- Чем полезнее материал для живых людей, тем лучше удержание на странице, репосты, естественные ссылки и т. д. Никакие технические ухищрения не спасут, если контент не удовлетворяет реальным потребностям аудитории.

В целом SEO-сообщество сходится во мнении, что Google и Яндекс больше ориентируются на полезность, релевантность и глубину материалов, а не на способ их создания. Если AI-контент недоработан, содержит фактические ошибки и много «воды», он, скорее всего, будет получать низкие позиции. Однако если текст (даже написанный нейросетью) адаптирован под потребности пользователей, содержит проверенные факты, имеет логичную структуру и не заспамлен, то поисковики обычно воспринимают его наравне с «ручным» контентом.

Главная рекомендация от экспертов — использовать нейросети как помощника для генерации идей и черновиков, однако обязательно проводить тщательную редактуру, проверять факты и дополнять материал человеческой экспертизой. Именно такой подход повышает шансы на высокие позиции и долгосрочный положительный эффект.

Опыт еТХТ: как биржа контента адаптируется к эпохе AI-текстов

С приходом нейросетевых технологий наша биржа контента eTXT также пережила заметную трансформацию. С одной стороны, мы наблюдаем растущий интерес к автоматической генерации текстов, но одновременно с этим столкнулись с рядом проблем:

- Ощутимое снижение качества контента. Нейросети часто грешат различного рода неточностями, неоднозначными формулировками и искажением фактов.

- Участившиеся отказы от работ, выполненных нейросетью. Из 10 отклоненных текстов 7 работ заказчики отказываются принимать из-за «следа» нейросети. Такие низкокачественные материалы, которые не дают читателю конкретную пользу, хуже ранжируются в поисковой выдаче.

Для успешного продвижения в поисковиках важно отличать тексты, созданные человеком, от сгенерированных нейросетью. Полагаться на честность авторов не всегда возможно, поэтому на помощь приходят специальные сервисы проверки. Недавно мы запустили свой детектор ИИ, который быстро проанализирует структуру, лексику и точно определит вероятную природу происхождения контента. Это удобно для SEO-специалистов, редакторов, владельцев сайтов, стремящихся к высокому ранжированию и репутационной прозрачности.

Благодаря такому решению вы не только избежите проблем с поисковыми алгоритмами, но и повысите доверие читателей. А значит, сможете совмещать технологические инновации с живым словом, оставаясь на передовой SEO.

Итак, что же делать, если детектор ИИ показал высокий процент машинного текста? Ответ один — материал нужно дорабатывать. Важно проверить все факты, убрать малополезную информацию и повторы, исправить возможные грамматические ошибки и т. д.

Мы провели внутренний анализ и обнаружили, что за последний год резко вырос спрос на «очеловечивание» машинных текстов и выполнение фактчекинга. Число заказов на редактуру и дописывание сгенерированных материалов на еТХТ выросло почти на 112% по сравнению с прошлым годом. Сейчас каждый третий заказчик приходит с запросом «перепишите, чтобы можно было публиковать».

Наша Биржа контента eTXT также активно использует в своей работе ИИ. Однако все материалы обязательно проходят фактчекинг, редактируются и дополняются полезной информацией.

В целом пришли к выводу, что нейросети действительно облегчают и ускоряют процесс создания контента, но без экспертной проработки и правок нельзя рассчитывать на его конкурентоспособность и выход в топ поиска.

Человек плюс нейросеть — лучший симбиоз

Массовое внедрение ИИ-контента уже кардинально меняет SEO-индустрию. Сайты накапливают огромные объемы сгенерированных текстов.

В 2023 году Content Marketing Institute провел исследование, которое показало, что уже более 67% маркетологов используют возможности нейросетей при создании текстов. Но 80% специалистов придерживаются мнения, что сгенерированный контент обязательно нужно редактировать и «допиливать».

ИИ давно научился строить грамотные предложения. Но у любого алгоритма есть пределы. Он может ошибаться в данных, смешивать факты, не учитывать специфику рынка. В итоге появляются тексты, которые не вписываются в контекст. Стилизация под бренд тоже может страдать, если подходить к вопросу формально.

Выигрывают те, кто совмещает возможности ИИ с человеческим творческим подходом и аналитикой. Полный переход на нейросети чаще всего приводит к падению поведенческих факторов и потере позиций.

Андрей Фадеичев, создатель Биржи контента еТХТ: «Нельзя отрицать очевидные перемены, которые происходят в мире: искусственный интеллект уже претендует на многие ниши и начинает замещать отдельных специалистов. От ИИ не нужно и нельзя отказываться, но важно научиться правильно работать со сгенерированным контентом, проверяя и дополняя его. Конечно, мы стараемся идти в ногу со временем и удовлетворять запросы заказчиков. Поэтому теперь на нашей площадке есть детектор ИИ. С помощью этого сервиса вы сможете защитить себя от некачественного сгенерированного контента».

Таким образом, сегодня растет востребованность копирайтеров, которые не ограничиваются прямой генерацией текста, а используют искусственный интеллект в качестве вспомогательного инструмента. Навыки составлять эффективные промпты, корректировать и совершенствовать результат, который выдает нейросеть, позволяют создавать по-настоящему качественный, «живой» контент. Такой комплексный подход — сочетание потенциала ИИ и творческих человеческих навыков — обеспечивает высокий уровень экспертности и доверия к конечному продукту.

***

Эпоха SEO изменилась: чтобы быть в топе, нужен не просто контент, а качественный и проверенный. Регистрируйтесь на eTXT — вы сможете проверить текст на уникальность и определить процент сгенерированного ИИ текста с помощью нашего AI-детектора. Находите проверенных исполнителей, которые знают, как работать с ИИ, и помогут вам создавать контент, который алгоритмы оценят за качество, а пользователи — за пользу.

Регистрация

Регистрация